前几天,腾讯混元DiT模型宣布开源训练代码,同时还宣布开源混元 DiT LoRA 小规模数据集训练方案和可控制插件 ControlNet。

腾讯混元文生图还是国内首个中文原生的 DiT架构文生图开源模型,用户在通过混元的 DiT训练代码进行精调的时候,可以直接使用中文的数据与标签,无需再将数据翻译成英文。

别的我就不多说了,光是这一点,就足以对腾讯喊一声:牛X。

可能很多人并不太知道什么是DiT架构,其实作为非计算机专业的人,特别还不是理科出身的,这些概念我也研究了好长时间,今天算是献丑吧,简单科普一下。

DiT架构,即Diffusion Transformer架构,是一种结合了Transformer架构的扩散模型,主要用于图像和视频生成任务。它能够高效地捕获数据中的依赖关系并生成高质量的结果。

这里面还提到了一个词,Transformer。Transformer架构是一种深度学习模型架构,主要用于自然语言处理(NLP)和其他序列到序列的任务。问题来了,这句话啥意思呢,举个栗子:

-

自然语言处理:如机器翻译、文本摘要、情感分析等。

-

其他序列到序列的任务如语音识别、图像描述生成等。

我们所熟知的ChatGPT就是基于Transformer架构开发的,而ChatGPT中GPT的英文全称是Generative Pre-Trained Transformer(生成式预训练Transformer模型),具体啥意思不详细讲了,简单来说就是可以进行数据训练的、文本生成的深度模型模型。

此前,腾讯混元文生图大模型已经在Github等平台发布,才一个月的时间Github Star数达到2.4k。

![图片[1]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-32f0db51c28a819ee6161b48a70a09c1.png)

那刚才说的LoRA模型和ControlNet又是啥呢?

1、LoRA模型

全称Low-RankAdaptation of Large Language Models,是一种用于微调大型语言模型的低秩适应技术。

大概意思就是使用几张照片,设计固定好一个专属形象,模样不动的情况下,对服饰、妆容、动作进行微调。

或者说一种固定的风格,主体会随着不同情况进行更换,比如草间弥生的大原点风格,可以设计成茶杯、书包、家用电器、盲盒等。

比如说青花瓷风格,可以设计成盘子、香插、书本等等。

如果有用过AI 写真的小伙伴会发现,在使用AI写真的时候,你是要上传十几张自己的各角度照片去训练模型,这就是在训练LoRA模型。

混元DiT本次发布的专属LoRA插件,支持开发者最少仅需一张图即可创作出专属的模型。比如,导入四张青花瓷图片与相应的提示词,即可完成模型训练,创建了一个“青花瓷”生成模型:用户输入简单提示词,即可生成想要的青花瓷图像。

部分训练数据:

![图片[2]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-13af772dac53d119d093b99d4a428282.png)

训练后模型的推理结果示例:

![图片[3]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-7a1fb34c881668c9cbf9219668eaa7d1.png)

2、ControlNet插件

ControlNet插件是一种基于神经网络的插件,用于更精细地控制生成图像的各种参数,如人物姿势、景深、线稿上色等。

目前,腾讯混元提供了能提取与应用图像的边缘(canny)、深度(depth)、人体姿势(pose)等条件的三个首发ControlNet模型,让开发者直接使用其进行推理。

![图片[4]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-bc755a9402aa52aba902c1f4534ccf9d.png)

其实今天我并不是来科普这些知识的,差点跑偏了……

我就是想感叹一下腾讯混元的文生图多么好用:

1、先看来速度。

![图片[5]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-80119133f2fd4272f80f7e6a1dcd75e1.png)

早上 7 点钟,我让它生成一副宫保鸡丁的图片,掐着时间看了一下,7.66 秒钟!快啊……

再来一个,北京故宫的早上,时间 8.52 秒……总之一个字:绝。

![图片[6]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-5b53014e72d9b3e17e55076919e32d6d.png)

2、人像

一个中国的 4 岁女孩,穿着古装长衫,大眼睛,中古古代,摄影风格,汉服。

![图片[7]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-1bc03dee76d107bbe6369593bf847a26.png)

一个中国男青年在飞机场,穿着休闲装,背着双肩包,机场内部,摄影风格,高度详细。

![图片[8]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-d0abababc9d9551a4a4a3f2a496440fa.png)

生成一个中国中老年男人在乡野,穿着朴素,站在稻田旁,远处山峦,近景,摄影风格,摄影照片,高度真实。

![图片[9]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-42d22cf4b99e56d7a8e1032acb432433.png)

真是……又快又准又好,谁看了不说一句炸裂。

![图片[10]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-ca574a4e945e9f712d64203b80104c73.png)

![图片[11]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-bf1e460203e1a18368e25f69c62d8c76.png)

![图片[12]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-6279da6e25d60f2c220bbf2474330f76.png)

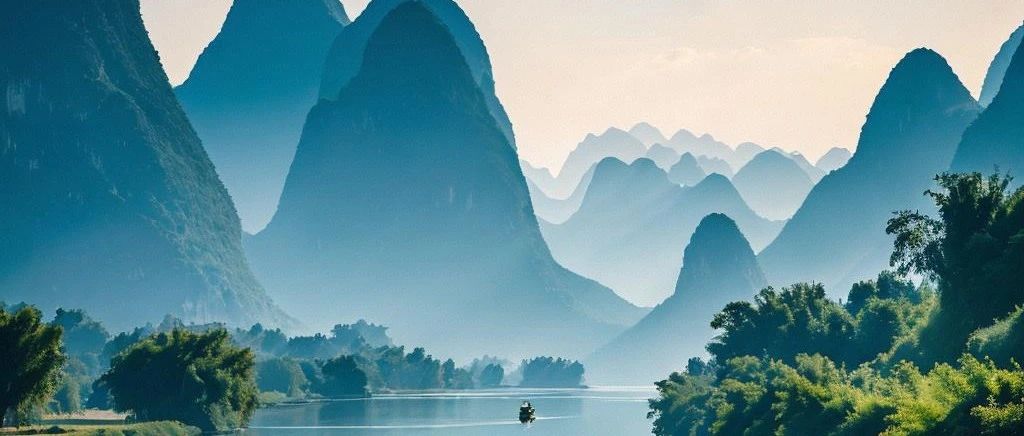

「轻舟已过万重山,水墨画风格。」

![图片[13]-过于低调的文生图工具:腾讯混元大模型。-夜影资源](https://www.maikeking.top/wp-content/uploads/2024/09/frc-7c66a7863e44d633fb470dd75fa352bc.png)

暂无评论内容